稳定安全的算力底座,极快至简的模型训练 稳定安全的算力底座,极快至简的模型训练 支持万节点计算集群管理 大规模分布式训练能力,加速大模型研发 零代码自动学习,AI应用高灵活、低门槛 零代码自动学习,AI应用高灵活、低门槛 可根据标注数据自动设计模型、自动调参、自动训练、自动压缩和部署模型 支持图像分

支持三方开源大模型,加速客户大模型业务上线 构建大模型应用开发工具链,使能大模型开箱即用 构建大模型应用开发工具链,完善云上数据清洗|模型微调|部署|Prompt|评测|Agent,大模型应用开发效率提升; 原生昇腾云组件Agent,构建“大模型+云组件”组合竞争力,如搜索Agent,大数据Agent等,使能云上存量用户零迁移构建大模型应用;

盘古大模型 概览 盘古NLP大模型 盘古CV大模型 盘古多模态大模型 盘古预测大模型 盘古科学计算大模型 概览 盘古NLP大模型 盘古CV大模型 盘古多模态大模型 盘古预测大模型 盘古科学计算大模型 盘古CV大模型 盘古CV大模型 AI for Industries 大模型重塑千行百业

化应用 大模型混合云十大创新技术 大模型混合云十大创新技术 了解详情 十大创新技术 加速构建企业专属大模型 十大创新技术 加速构建企业专属大模型 围绕企业大模型构建关键过程,聚焦根技术,为AI原生系统性创新 围绕企业大模型构建关键过程,聚焦根技术,为AI原生系统性创新 多样性算力调度

挖掘数据规律和背后趋势,更好实现智能决策 插件应用集成 通过插件开发模型,与预置插件相匹配使用,快速集成应用,灵活匹配不同的业务场景 为什么选择盘古NLP大模型 超千亿大模型参数 超千亿大模型参数 超千亿参数的中文预训练大模型,它利用大数据预训练、对多源丰富知识相结合,并通过持续

盘古大模型 概览 盘古NLP大模型 盘古CV大模型 盘古多模态大模型 盘古预测大模型 盘古科学计算大模型 概览 盘古NLP大模型 盘古CV大模型 盘古多模态大模型 盘古预测大模型 盘古科学计算大模型 盘古预测大模型 盘古预测大模型 AI for Industries 大模型赋能千行百业

盘古大模型:解决行业难题,释放AI生产力 盘古大模型:解决行业难题,释放AI生产力 5大基础大模型,夯实基础能力 5大基础大模型,夯实基础能力 盘古NLP大模型 业界首个超千亿参数的中文预训练大模型 盘古CV大模型 基于海量图像、视频数据和盘古独特技术构筑的视觉基础模型 盘古多模态大模型 融合语言和

端到端生产工具链,一致性开发体验 线上线下协同开发,开发训练一体化架构,支持大模型分布式部署及推理 AI工程化能力,支持AI全流程生命周期管理 AI工程化能力,支持AI全流程生命周期管理 支持MLOps能力,提供数据诊断、模型监测等分析能力,训练智能日志分析与诊断 容错能力强,故障恢复快 容错能力强,故障恢复快

盘古大模型 概览 盘古NLP大模型 盘古CV大模型 盘古多模态大模型 盘古预测大模型 盘古科学计算大模型 概览 盘古NLP大模型 盘古CV大模型 盘古多模态大模型 盘古预测大模型 盘古科学计算大模型 盘古多模态大模型 盘古多模态大模型 AI for Industries 大模型重塑千行百业

《互联网信息服务算法推荐管理规定》明确,具有舆论属性或者社会动员能力的算法推荐服务提供者应当在提供服务之日起十个工作日内通过互联网信息服务算法备案系统填报服务提供者的名称、服务形式、应用领域、算法类型、算法自评估报告、拟公示内容等信息 方便

湘江鲲鹏目前在人工智能大模型领域拥有算力、数据、算法三大关键要素的经验积累,构建了大模型三个方面的差异化竞争力,盘古大模型AI专业服务覆盖从前期咨询、规划设计,到数据工程、模型训练,再到应用工程及模型运维的完整流程。基于华为盘古提供的AI专业服务包,致力于为企业提供一站式人工智能解决方案

angChain等流行的大模型开发框架,构建企业级AI应用;团队拥有成熟的软件工程技术和管理能力。6. 大模型使用的技术支持,用户使用大模型平台,解答用户使用过程遇到的问题;大模型与应用对接集成,以及进行日常巡检、故障处理、模型升级等服务。4. 工业数据模型(CAD模型、CAE模

太杉天尊大模型AIGC场景解决方案是以AI场景解决方案为核心的全栈Maas综合方案,助力政企客户灵活部署(可公有可私有部署)。具备自研的行业模型能力,主要用于政府/公安/教育等行业的数据处理、文本处理以及多模态处理等多场景。太杉天尊大模型AIGC场景解决方案,是一款专为满足政府企

公司集成了世界领先的底层大模型,具备打通跨模型和工具链的平台,提供从需求分析、数据收集、模型设计、训练优化、评估、系统集成、用户界面设计、部署维护、合规性检查、技术支持、性能监控、扩展性设计、定制服务到持续研发一站式AI大模型定制研发服务。光启慧语是一家围绕大模型全栈开展技术研发和产

&撰写根据大模型微调数据标注规范,通过配套工具进行数据标注。 八、数据转换与导入 完成数据格式的转换,可进行跨网络环境的数据导入。 九、调优方案设计 根据大模型训练及调优工具和平台,输出大模型调优方案。 十、模型训练实施1. 基于大模型训练所需的云服务,完成大模型训练及微调。2.

数据质量。4. 模型训练:设计调优方案,实施模型训练,并进行模型评测。熟悉盘古大模型工作流和云服务操作,确保模型效果优化。5. 应用工程:提供基于大模型能力的Agent开发和应用对接服务。具备良好的软件开发和沟通能力,实现大模型与应用的无缝对接。6. 模型运维: 提供技

天尊大模型AIGC场景解决方案配套服务是太杉AIGC解决方案的人工服务,是以AI应用解决方案为核心的全栈Maas综合方案,助力政企客户灵活部署(可公有可私有部署)。主要用于政府/公安/教育等行业的数据处理、文本处理以及多模态处理等多场景。天尊大模型AIGC场景解决方案配套服务是太

,只需人工提供极少量的标注数据,通过平台的自动标注功能,能够提升50%的标注效率,节省人力及时间成本;3、解决模型训练门槛高问题,可视化的模型训练界面,自动推荐训练参数,5分钟快速上手,模型训练成本降低70%;4、克服算法只能解决单一业务场景问题,通过拖拽的方式将多个模型串联起来

中调试分布式训练。 了解更多 收起 展开 模型训练加速 收起 展开 针对AI训练场景中大模型Checkpoint保存和加载带来的I/O挑战,华为云提供了基于对象存储服务OBS+高性能文件服务SFS Turbo的AI云存储解决方案。 了解更多 模型训练最佳实践示例 模型训练入门级使用教程,小白也能快速上手。

ModelArts训练管理 ModelArts训练管理 ModelArts训练管理模块用于创建训练作业、查看训练情况以及管理训练版本。在训练模块的统一管理下,方便用户试验算法、数据和超参数的各种组合,便于追踪最佳的模型与输入配置,您可以通过不同版本间的评估指标比较,确定最佳训练作业。 Mo

华为云盘古大模型 华为云盘古大模型 AI for Industries 大模型重塑千行百业 AI for Industries 大模型重塑千行百业 盘古大模型致力于深耕行业,打造金融、政务、制造、矿山、气象、铁路等领域行业大模型和能力集,将行业知识know-how与大模型能力相结合

ModelArts分布式训练 ModelArts分布式训练 ModelArts提供了丰富的教程,帮助用户快速适配分布式训练,使用分布式训练极大减少训练时间。也提供了分布式训练调测的能力,可在PyCharm/VSCode/JupyterLab等开发工具中调试分布式训练。 ModelA

ModelArts训练之超参搜索 ModelArts训练之超参搜索 ModelArts训练中新增了超参搜索功能,自动实现模型超参搜索,为您的模型匹配最优的超参。ModelArts支持的超参搜索功能,在无需算法工程师介入的情况下,即可自动进行超参的调优,在速度和精度上超过人工调优。 Mo

源,包括高性能算力,高速存储和网络带宽等基础设施,即“大算力、大存力、大运力”的AI基础大设施底座,让算力发展不要偏斜。 从过去的经典AI,到今天人人谈论的大模型,自动驾驶,我们看到AI模型的参数及AI算力规模呈现出指数级的爆发增长,对存储基础设施也带来全新的挑战。 1、高吞吐的数据访问挑战:随着企业使用

块,允许使用者导入部门、角色、人员等信息,从而生成并调动Astro Flow工作流开发、Astro Canvas可视化大屏开发、Astro Zero轻应用开发三大子服务,据自身需求,回归业务核心进行构建。华为云Astro低代码开发平台覆盖行业场景应用,全面促进企业数字化进程。 Astro

ModelArts支持本地准备模型包,编写模型配置文件和模型推理代码,将准备好的模型包上传至对象存储服务OBS,从OBS导入模型创建为AI应用。 制作模型包,则需要符合一定的模型包规范。模型包里面必需包含“model”文件夹,“model”文件夹下面放置模型文件,模型配置文件,模型推理代码文件。

ModelArts是面向AI开发者的一站式开发平台,提供海量数据预处理及半自动化标注、大规模分布式训练、自动化模型生成及端-边-云模型按需部署能力,帮助用户快速创建和部署模型,管理全周期AI工作流。 “一站式”是指AI开发的各个环节,包括数据处理、算法开发、模型训练、模型部署都可以在Mo

ai大模型训练花费分布

ModelArts 是面向AI开发者的一站式开发平台,提供海量数据预处理及半自动化标注、大规模分布式训练、自动化模型生成及端-边-云模型按需部署能力,帮助用户快速创建和部署AI智能模型,管理全周期AI工作流。

在AstroZero中,通过配置ModelArts连接器,可实现AstroZero与华为ModelArts对接,用于 图像识别 、 文字识别 等AI(人工智能)场景。例如,对花卉类图片进行识别,识别出具体花卉品种。

前提条件

- 已获取AK(Access Key ID)、SK(Secret Access Key),即访问密钥对,具体操作请参见获取AK/SK。

- 本场景是对花卉类图片进行识别,请提前在ModelArts上创建并部署上线用于花卉识别的模型,具体操作请参见使用AI Gallery的订阅算法实现花卉识别。

创建ModelArts连接器

- 参考登录AstroZero新版应用设计器中操作,进入应用设计器。

- 在左侧导航栏中,选择“集成”。

- 单击“连接器”中的“ 连接器实例”,进入连接器实例页面。

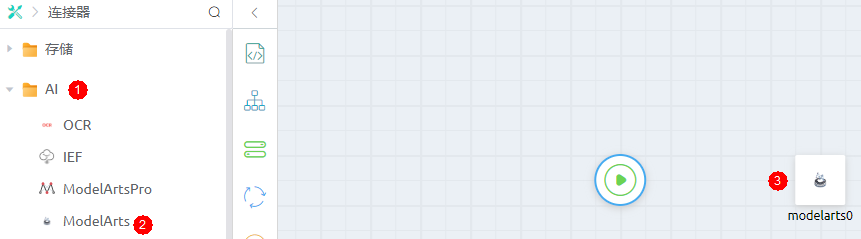

- 在左侧导航栏中,选择“AI > ModelArts”。

- 在右侧页面单击“+”,设置ModelArts对接信息。

图1 创建ModelArts

表1 创建ModelArts连接器参数说明 参数

说明

名称

新建连接器的名称。命名要求如下:

- 长度不能超过64个字符,包括前缀命名空间的长度。

说明:

名称前的内容为命名空间,在AstroZero中为了避免不同租户间数据的重名,租户在首次创建应用时需要先定义一个命名空间。一个租户只能创建一个命名空间,创建后不支持修改。

- 必须以英文字母开头,只能由英文字母、数字或单下划线组成,且不能以下划线结尾。

访问密钥ID

与私有访问密钥关联的唯一标识符,访问密钥ID和私有访问密钥一起使用,对请求进行加密签名。配置为前提条件中“AK”的值。

访问密钥

私有访问密钥,与访问密钥ID结合使用的密钥,对请求进行加密签名,可标识发送方,并防止请求被修改。配置为前提条件中“SK”的值。

区域

选择对接ModelArts的服务区域。

项目ID

ModelArts服务区域,对应的项目ID。

描述

根据实际需求,输入连接器的描述信息。

取值范围:1~255个字符。

打包当前配置

选中该选项后,应用打包时会将当前配置的连接器信息(包括访问密钥和密钥)一并带入应用包中。例如,如果应用包发布到运行环境,当前配置默认会被同步到运行环境中。如果不勾选,则内容不会打包发布到运行环境,此时需要您参考管理应用中的连接器中操作,创建对应的连接器。

默认为选中,对信息敏感的场景,建议不勾选。

- 长度不能超过64个字符,包括前缀命名空间的长度。

- 设置完成后,单击“保存”。

- (可选)测试是否能可识别花卉图片。

- 在连接器详情页面,单击“测试”。

- 配置测试参数,单击“测试”。

选择类型:识别的主体可以是图片或者文本信息。本示例选择“图片文件”,并上传待识别的图片。

- 图片URL:识别的主体是图片时,可选择“图片URL”并设置图片的URL。

- 图片文件:识别的主体为图片时,可选择“图片文件”,直接拖入图片文件。

- 文本信息:识别的主体为文本时,配置为“文本信息”,并填写具体的文本。

- 模型Apig-Code:用于AstroZero调用ModelArts中,已上线的服务。

- 已执行前提条件中操作,即已部署上线用于花卉识别的模型。

- 在ModelArts管理控制台左侧菜单栏中,选择“部署上线 > 在线服务”,进入在线服务管理页面。

- 单击目标服务名称,进入服务详情页面。

- 选择“调用指南”页签,查看“API接口地址”。

- 模型Id:ModelArts管理控制台中,已上线服务的服务ID。

- 已执行前提条件中操作,即已部署上线用于花卉识别的模型。

- 在ModelArts管理控制台左侧菜单栏中,选择“部署上线 > 在线服务”,进入在线服务管理页面。

- 单击目标服务名称,进入服务详情页面。

- 查看服务ID值。

在脚本中调用连接器

在脚本中,调用连接器,实现调用ModelArts的接口。

- 参考创建空白AstroZero脚本中操作,创建一个空白脚本。

- 在脚本编辑器中,输入如下代码。

import * as modelarts from 'modelarts'; export class Input { @action.param({ type: "String", required: false, description: "the image url" }) url: string; @action.param({ type: "String", required: false, description: "the base64 coded image" }) image: string; @action.param({ type: "String", required: false, description: "" }) apigCode: string @action.param({ type: "String", required: false, description: "" }) modelId: string } export class Output { @action.param({ type: "string" }) result: string; } export class testModelarts { @action.method({ input: "Input", output: "Output", description: "modelartspro test case" }) run(input: Input): void { // 填写实例化的modelartspro连接器名称 let client = modelarts.newClient("testArts") let result = null result = client.modelArtsWithURL(input.url, input.apigCode, input.modelId); console.log(result) return result } }其中,代码modelarts.newClient("testArts")中“testArts”为连接器的名称。如果连接器名称中带有命名空间前缀,代码中也需要携带。

- 单击脚本编辑器页面上方的

,保存脚本。

,保存脚本。 - 保存成功后,单击

,运行脚本。

,运行脚本。 - 在页面底部“输入参数”中,设置输入请求参数,单击测试窗口右上角的

。

。

{ "url": "https://XXXXXXXXX/testmodelarts.jpg", "apigCode": "bec274062225485b95fbcd4d6e8f128a", "modelId": "5ecac550-eefe-4437-9767-57eca07fa91f" }其中,“url”请设置为图片的URL。

- 在输出参数页签,可查看到识别的结果。

{ "predicted_label": "roses", "scores": [ [ "roses", "0.947" ], [ "daisy", "0.050" ], [ "tulips", "0.002" ], [ "dandelion", "0.000" ], [ "sunflowers", "0.000" ] ] } - 单击脚本编辑器页面上方的

,启用脚本。

,启用脚本。

在服务编排中调用连接器

在服务编排中,调用连接器,实现与ModelArts的对接。

- 参考创建空白AstroZero服务编排中操作,创建一个空白服务编排。

- 创建该服务编排的入参和出参变量。

由于该服务编排调用的是ModelArts服务接口,需要定义该服务编排的入参和出参,与接口的入参和出参类型保持一致。

- 在服务编排设计页面右侧,选择

。

。 - 在全局上下文页面,单击“变量”后的加号。

图3 创建变量

- 修改变量名为“image”。

图4 设置变量

- 新增表2中其他变量,单击开始图元

,在右侧设置整个服务编排的入参、出参。

图5 设置入参、出参

,在右侧设置整个服务编排的入参、出参。

图5 设置入参、出参

- 在服务编排设计页面右侧,选择

- 在服务编排设计页面左侧,选择“连接器 > AI”,拖拽“ModelArts”图元至画布中。

ModelArts是系统预置的与ModelArts对接的接口。

图6 拖拽ModelArts图元至画布中

- 选中ModelArts图元,在右侧单击

,选择创建ModelArts连接器中创建的连接器“testArts”。

,选择创建ModelArts连接器中创建的连接器“testArts”。 - 单击

,设置动作参数。

图7 设置动作参数

,设置动作参数。

图7 设置动作参数

- 动作:调用的ModelArts的具体接口。本示例选择“modelarts_with_image”。

- modelarts_with_url:根据图片URL识别图片。

- modelarts_with_image:根据图片文件识别图片。

- modelarts_with_text:根据文本信息识别文本。

- 输入参数:调用接口的输入参数。在“目标”中选择参数,在“源”中拖入全局上下文中的对应变量。

- 输出参数:调用接口的输出参数。

- “源”中选择“result”,“目标”中拖入全局上下文中的“result”,用于接收调用结果。

- “源”中选择“error”,“目标”中拖入全局上下文中的“error”,用于接收错误信息。

- 动作:调用的ModelArts的具体接口。本示例选择“modelarts_with_image”。

- 连接开始和ModelArts图元。

图8 连接图元

- 单击页面上方的

,保存服务编排。

,保存服务编排。 - 保存成功后,单击

,运行服务编排。

,运行服务编排。 - 设置输入参数后,单击“运行”。

{ "image": "https://XXXXXXXX/testmodelarts.jpg", "apigCode": "bec274062225485b95fbcd4d6e8f128a", "modelID": "5ecac550-eefe-4437-9767-57eca07fa91f" }其中,“image”为图片的URL。若输出识别结果,表示成功调用连接器。

图9 输出结果

- 单击编辑器上方的

,启用服务编排。

,启用服务编排。

ai大模型训练花费分布常见问题

更多常见问题 >>-

在自然语言处理(NLP)领域中,使用语言模型预训练方法在多项NLP任务上都获得了不错的提升,广泛受到了各界的关注。本课程将简单介绍一下预训练的思想,几个代表性模型和它们之间的关系。

-

ModelArts模型训练旨在提升开发者模型训练的开发效率及训练性能。提供了可视化作业管理、资源管理、版本管理等功能,基于机器学习算法及强化学习的模型训练自动超参调优;预置和调优常用模型,简化模型开发和全流程训练管理。

-

训练管理模块是ModelArts不可或缺的功能模块,用于创建训练作业、查看训练情况以及管理训练版本。模型训练是一个不断迭代和优化的过程。在训练模块的统一管理下,方便用户试验算法、数据和超参数的各种组合,便于追踪最佳的模型与输入配置,您可以通过不同版本间的评估指标比较,确定最佳训练作业。

-

盘古大模型致力于深耕行业,打造金融、政务、制造、矿山、气象、铁路等领域行业大模型和能力集,将行业知识know-how与大模型能力相结合,重塑千行百业,成为各组织、企业、个人的专家助手。

-

ModelArts提供了丰富的教程,帮助用户快速适配分布式训练,使用分布式训练极大减少训练时间。也提供了分布式训练调测的能力,可在PyCharm/VSCode/JupyterLab等开发工具中调试分布式训练。

-

模型转换,即将开源框架的网络模型(如Caffe、TensorFlow等),通过ATC(Ascend Tensor Compiler)模型转换工具,将其转换成昇腾AI处理器支持的离线模型。

更多相关专题

更多精彩内容

域名注册服务机构许可:黔D3-20230001 代理域名注册服务机构:新网、西数