AI开发平台MODELARTS-使用ModelArts Studio的Llama3.1-8B模型框架实现对话问答:步骤3:部署模型服务

步骤3:部署模型服务

- “llama3.1”模型创建成功后,在我的模型列表,单击操作列的“部署”,进入部署模型服务页面。

- 在部署模型服务页面,完成创建配置。

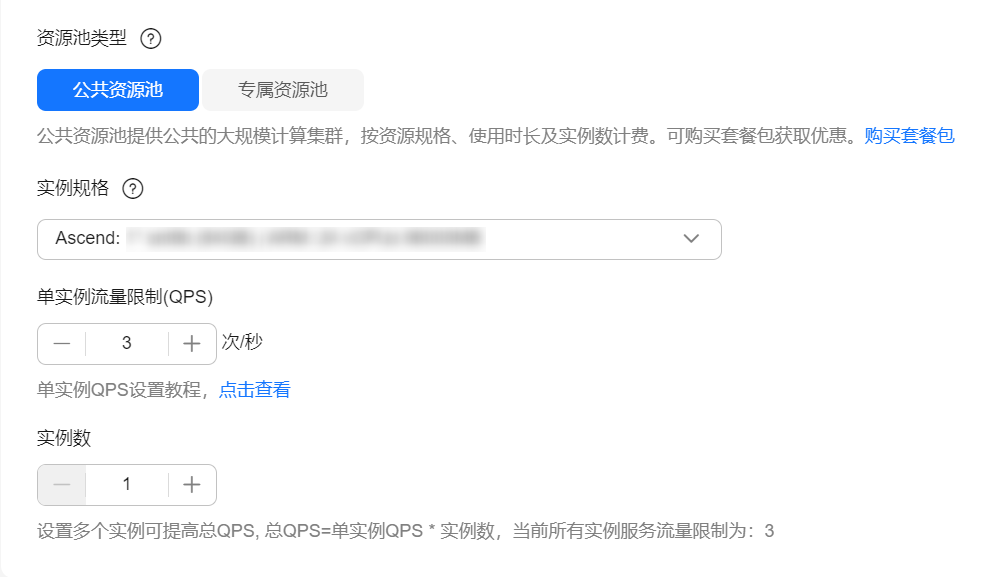

图5 资源设置

表2 部署模型服务 参数

说明

取值样例

服务设置

服务名称

自定义模型服务的名称。

service-llama3

描述

部署模型服务的简介。

-

模型设置

部署模型

当从“我的模型”进入部署模型服务页面时,此处默认呈现选择的模型。

llama3.1

资源设置

资源池类型

资源池分为公共资源池与专属资源池。

- 公共资源池供所有租户共享使用。

- 专属资源池需单独创建,不与其他租户共享。

公共资源池

实例规格

选择实例规格,规格中描述了服务器类型、型号等信息。

xxx

单实例流量限制(QPS)

设置待部署模型的单实例流量限制QPS。

3

实例数

设置服务器个数。增加实例个数可提高总QPS,“总QPS = 单实例QPS x 实例数”。

1

更多选项

事件通知

选择是否打开“事件通知”开关。

- 开关关闭(默认关闭):表示不启用 消息通知 服务。

- 开关打开:表示订阅消息通知服务,当任务发生特定事件(如任务状态变化或疑似卡死)时会发送通知。此时必须配置“主题名”和“事件”。

- “主题名”:事件通知的主题名称。单击“创建主题”,前往消息通知服务中创建主题。

- “事件”:选择要订阅的事件类型。例如“创建中”、“已完成”、“运行失败”等。

关闭

自动停止

当使用付费资源时,可以选择是否打开“自动停止”开关。

- 开关关闭(默认关闭):表示任务将一直运行。

- 开关打开:表示启用自动停止功能,此时必须配置自动停止时间,支持设置为“1小时”、“2小时”、“4小时”、6小时或“自定义”。启用该参数并设置时间后,运行时长到期后将会自动终止任务,准备排队等状态不扣除运行时长。

关闭

- 参数配置完成后,单击“提交”,创建部署任务。

在任务列表,当模型“状态”变成“运行中”时,表示模型部署完成。

下载AI开发平台MODELARTS用户手册完整版

下载AI开发平台MODELARTS用户手册完整版