AI开发平台MODELARTS-FlUX.1基于DevServer适配PyTorch NPU推理指导(6.3.911):步骤六:ComfyUI 0.2.2 服务调用

步骤六:ComfyUI 0.2.2 服务调用

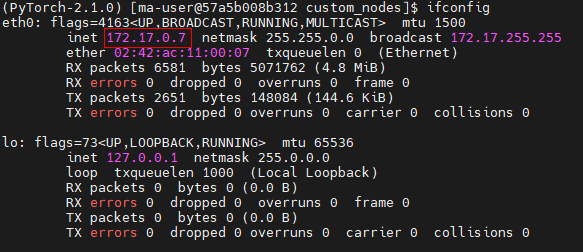

- 获取容器IP地址

在已启动的容器内,使用ifconfig命令获取容器IP,记为${container_ip_address},本例中为172.17.0.7。若无效可使用ip addr,或者自行寻找其他方式获取到容器IP。

图5 使用ifconfig命令获取容器IP

- 使用容器IP启动服务

cd ${container_work_dir}/ComfyUI python main.py --port ${port} --force-fp16 --listen ${container_ip_address}参数说明:

- port:为启动镜像时映射port

- container_ip_address:为容器IP,如上图的172.17.0.7

- 默认不使用图模式

- 若要使用图模式,需要配置环境变量 export GRAPH_MODE=1。如果使用了图模式,则首次推理时间较长,请耐心等待。

- 浏览器启动

浏览器启动时,需要使用宿主机IP,在浏览器中输入 http://${host_ip_address}:${port} ,例如:http://7.216.55.96:8585/

参数说明:

- host_ip_address:为宿主机IP地址

- port:为启动镜像时映射port

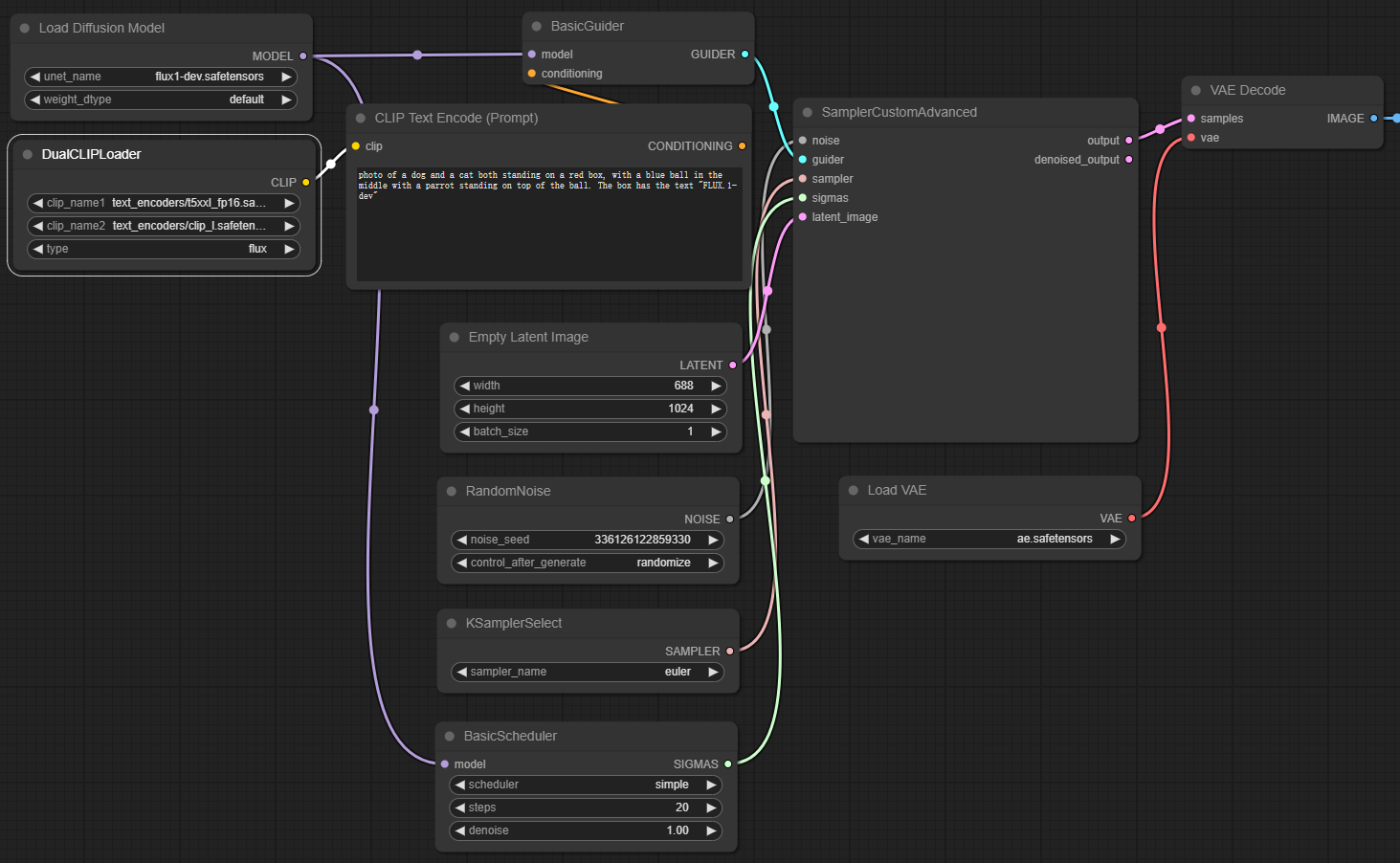

访问界面如下图。

图6 访问界面

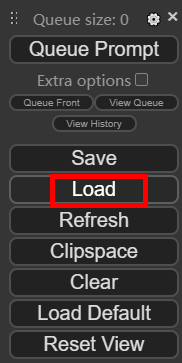

- 加载workflow文件,选择workflow-flux1-dev-KnSeTKHjvuTd0RiUDSmW-datou-openart.ai.json。

图7 加载workflow文件

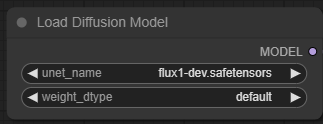

- 选择Diffusion model,单击选择flux1-dev.safetensors,如下图。

图8 选择flux1-dev.safetensors

- 选择clip模型,clip_name1选择text_encoders/t5xxl_fp16.safetensors,clip_name2选择text_encoders/clip_l.safetensors, 如下图。

图9 选择clip模型

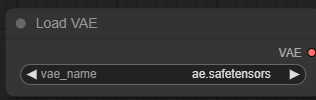

- 选择vae模型,如下图。

图10 选择vae模型

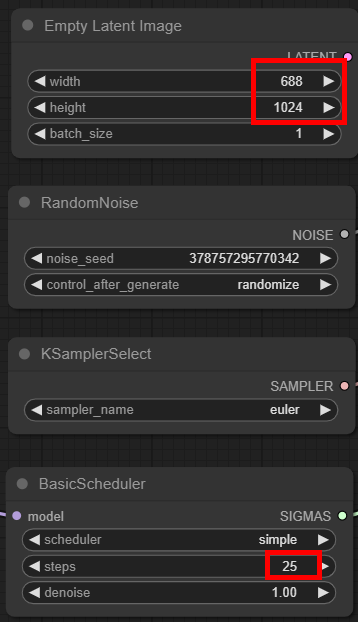

- 配置推理的参数,如width、height、batch_size等,本文以 688*1024,25步为例,如下图所示。

图11 配置推理参数

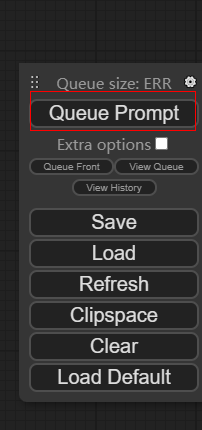

- 单击Queue Prompt加入推理队列进行推理,如下图

图12 推理队列

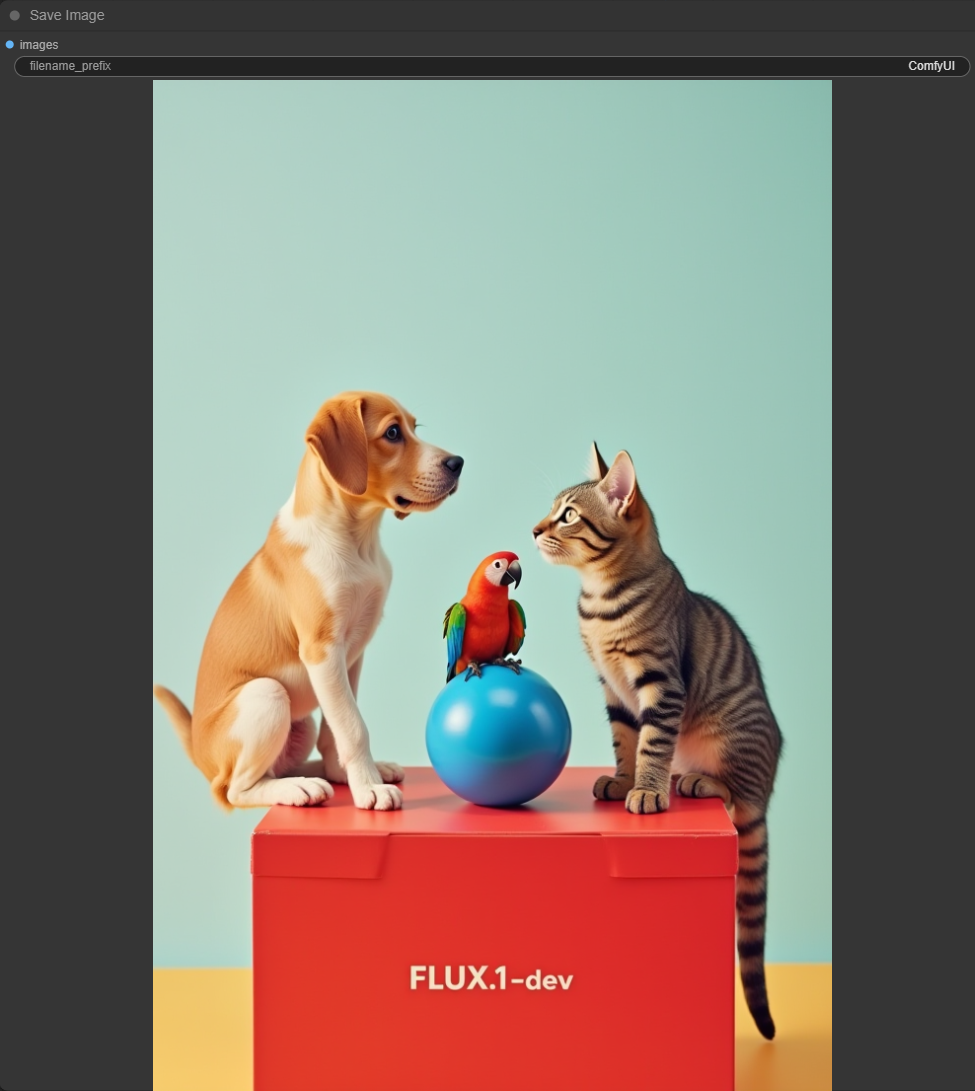

成功之后结果如下图所示。首次加载或切换模型推理时,需要加载模型并进行相关初始化工作,如果使用了图模式,则首次推理时间较长,请耐心等待。

图13 推理成功

下载AI开发平台MODELARTS用户手册完整版

下载AI开发平台MODELARTS用户手册完整版