数据湖探索 DLI-迁移Hive数据至DLI:步骤二:数据迁移

步骤二:数据迁移

- 配置 CDM 数据源连接。

- 配置源端 MRS Hive的数据源连接。

- 登录CDM控制台,选择“集群管理”,选择已创建的CDM集群,在操作列选择“作业管理”。

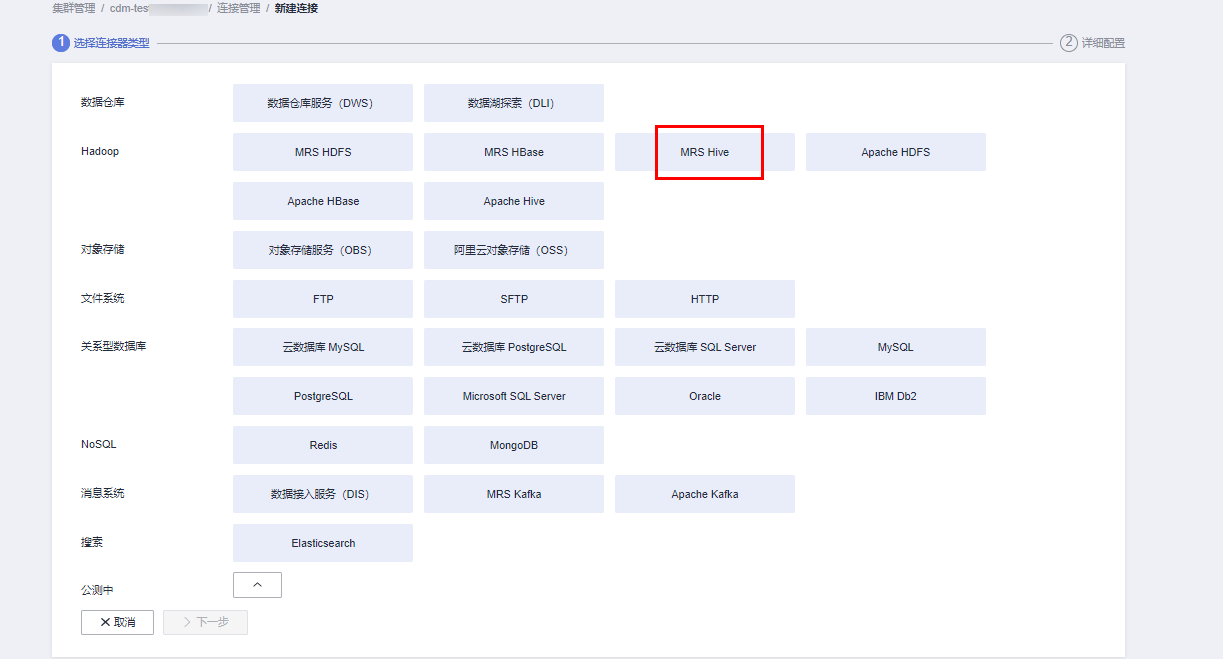

- 在作业管理界面,选择“连接管理”,单击“新建连接”,连接器类型选择“MRS Hive”,单击“下一步”。

图3 创建MRS Hive数据源连接

- 配置源端MRS Hive的数据源连接,具体参数配置如下。

表1 MRS Hive数据源配置 参数

值

名称

自定义MRS Hive数据源名称。例如当前配置为:source_hive

Manager IP

单击输入框旁边的“选择”按钮,选择当前MRS Hive集群即可自动关联出来Manager IP。

认证类型

如果当前MRS集群为普通集群则选择为SIMPLE,如果是MRS集群启用了Kerberos安全认证则选择为KERBEROS。

本示例选择为:KERBEROS。

Hive版本

根据当前创建MRS集群时候的Hive版本确定。当前Hive版本为3.1.0,则选择为:HIVE_3_X。

用户名

在3中创建的MRS Hive用户名。

密码

对应的MRS Hive用户名的密码。

其他参数保持默认即可。更多参数的详细说明可以参考CDM上配置Hive连接。图4 CDM配置MRS Hive数据源

- 单击“保存”完成MRS Hive数据源配置。

- 配置目的端 DLI 的数据源连接。

- 登录CDM控制台,选择“集群管理”,选择已创建的CDM集群,在操作列选择“作业管理”。

- 在作业管理界面,选择“连接管理”,单击“新建连接”,连接器类型选择“ 数据湖探索 (DLI)”,单击“下一步”。

图5 创建DLI数据源连接

- 配置目的端DLI数据源连接连接参数。具体参数配置可以参考在CDM上配置DLI连接。

图6 配置DLI数据源连接参数

配置完成后,单击“保存”完成DLI数据源配置。

- 配置源端 MRS Hive的数据源连接。

- 创建CDM迁移作业。

- 登录CDM控制台,选择“集群管理”,选择已创建的CDM集群,在操作列选择“作业管理”。

- 在“作业管理”界面,选择“表/文件迁移”,单击“新建作业”。

- 在新建作业界面,配置当前作业配置信息,具体参数参考如下:

图7 新建CDM作业作业配置

- 作业名称:自定义数据迁移的作业名称。例如,当前定义为:hive_to_dli。

- 源端作业配置,具体参考如下:

表2 源端作业配置 参数名

参数值

源连接名称

选择1.a中已创建的数据源名称。

数据库名称

选择MRS Hive待迁移的数据库名称。例如当前待迁移的表数据数据库为“default”。

表名

待建议Hive数据表名。当前示例为在DLI上创建数据库和表中的“user_info”表。

读取方式

当前示例选择为:HDFS。具体参数含义如下:

包括HDFS和JDBC两种读取方式。默认为HDFS方式,如果没有使用WHERE条件做数据过滤及在字段映射页面添加新字段的需求,选择HDFS方式即可。

HDFS文件方式读取数据时,性能较好,但不支持使用WHERE条件做数据过滤及在字段映射页面添加新字段。

JDBC方式读取数据时,支持使用WHERE条件做数据过滤及在字段映射页面添加新字段。

更多参数的详细配置可以参考:CDM配置Hive源端参数。

- 目的端作业配置,具体参考如下:

表3 目的端作业配置 参数名

参数值

目的连接名称

选择1.b已创建的DLI数据源连接。

资源队列

选择已创建的DLI SQL类型的队列。

数据库名称

选择DLI下已创建的数据库。当前示例为在DLI上创建数据库和表中创建的数据库名,即为“testdb”。

表名

选择DLI下已创建的表名。当前示例为在DLI上创建数据库和表中创建的表名,即为“user_info”。

导入前清空数据

选择导入前是否清空目的表的数据。当前示例选择为“否”。

如果设置为是,任务启动前会清除目标表中数据。

更多参数的详细配置可以参考:CDM配置DLI目的端参数。

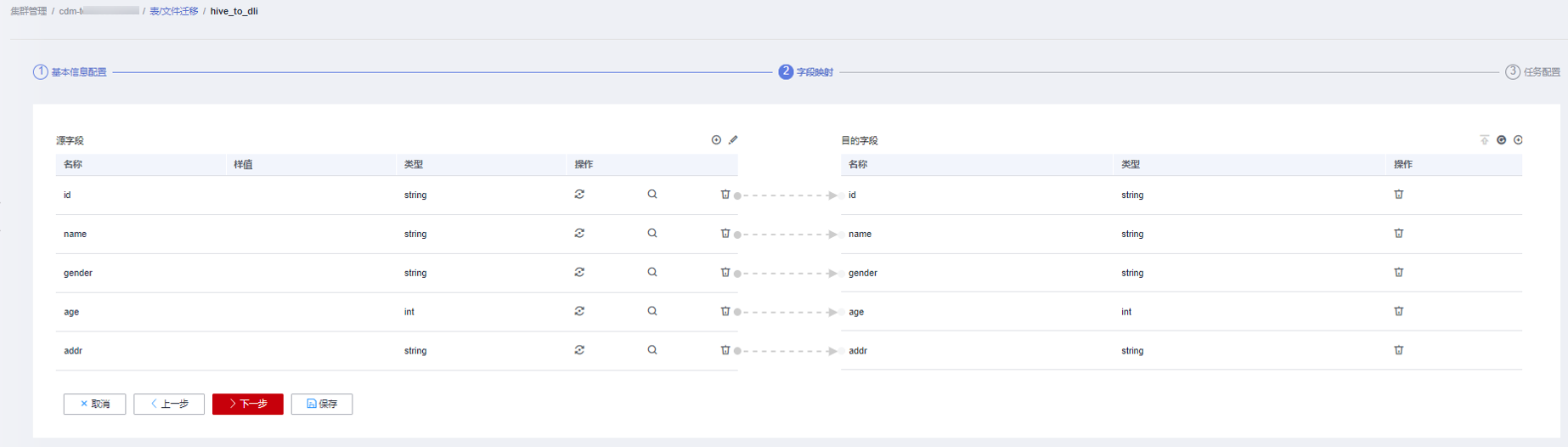

- 单击“下一步”,进入到字段映射界面,CDM会自动匹配源和目的字段。

- 如果字段映射顺序不匹配,可通过拖拽字段调整。

- 如果选择在目的端自动创建类型,这里还需要配置每个类型的字段类型、字段名称。

- CDM支持迁移过程中转换字段内容

图8 字段映射

- 单击“下一步”配置任务参数,一般情况下全部保持默认即可。

- 作业失败重试:如果作业执行失败,可选择是否自动重试,这里保持默认值“不重试”。

- 作业分组:选择作业所属的分组,默认分组为“DEFAULT”。在CDM“作业管理”界面,支持作业分组显示、按组批量启动作业、按分组导出作业等操作。

- 是否定时执行:如果需要配置作业定时自动执行,请参见配置定时任务。这里保持默认值“否”。

- 抽取并发数:设置同时执行的抽取任务数。这里保持默认值“1”。

- 是否写入脏数据:如果需要将作业执行过程中处理失败的数据、或者被清洗过滤掉的数据写入OBS中,以便后面查看,可通过该参数配置,写入脏数据前需要先配置好OBS连接。这里保持默认值“否”即可,不记录脏数据。

- 单击“保存并运行”,回到作业管理界面,在作业管理界面可查看作业执行进度和结果。

图9 迁移作业进度和结果查询

下载数据湖探索 DLI用户手册完整版

下载数据湖探索 DLI用户手册完整版