AI开发平台MODELARTS-多机多卡数据并行-DistributedDataParallel(DDP):训练流程简述

时间:2024-08-26 19:27:18

训练流程简述

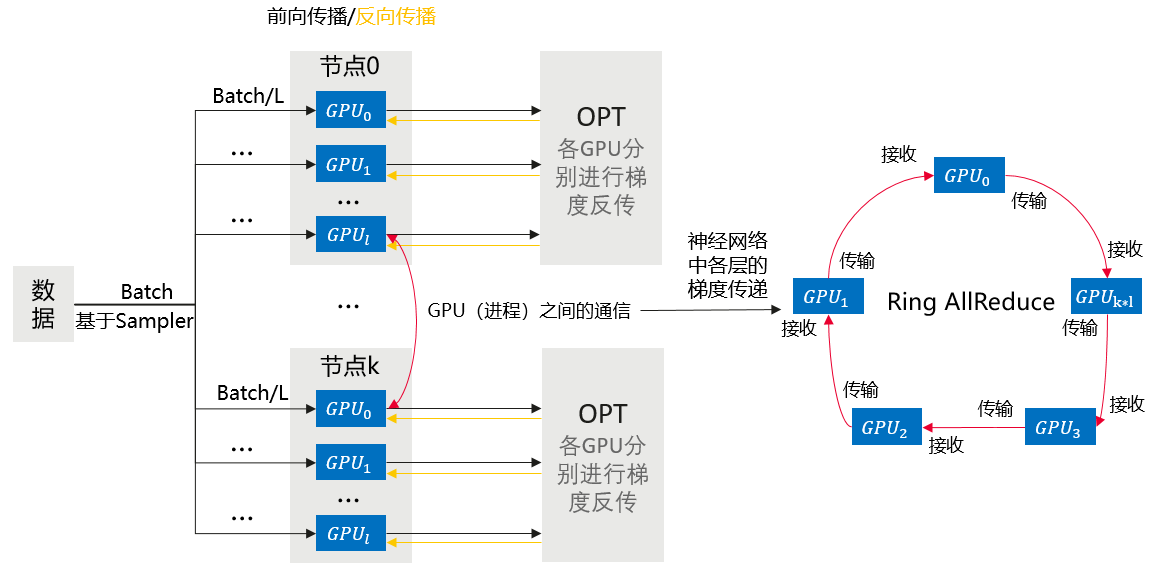

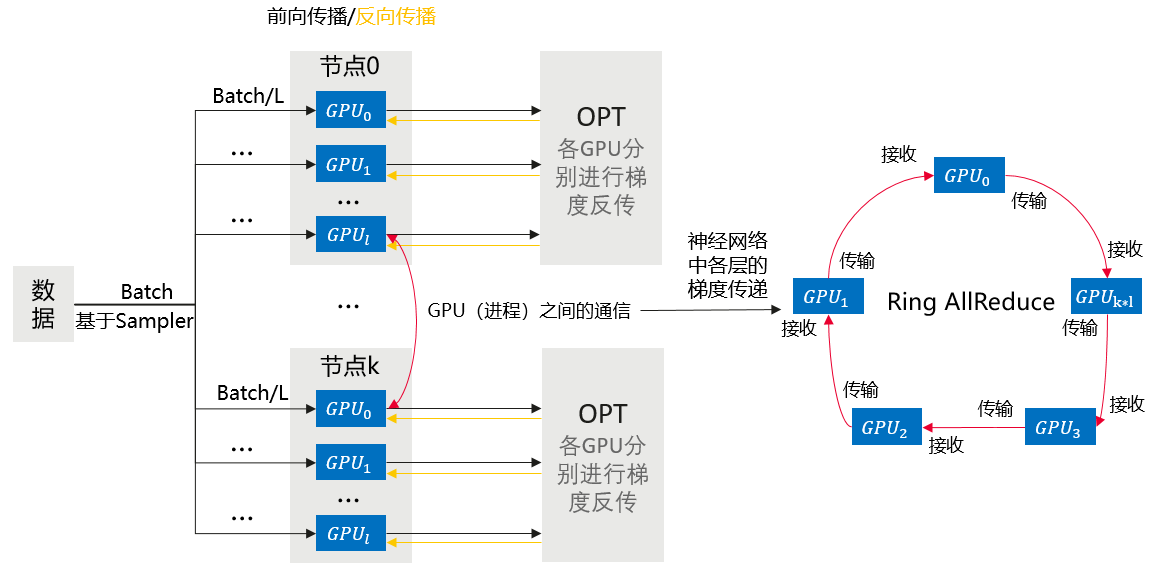

相比于DP,DDP能够启动多进程进行运算,从而大幅度提升计算资源的利用率。可以基于torch.distributed实现真正的分布式计算,具体的原理此处不再赘述。大致的流程如下:

- 初始化进程组。

- 创建分布式并行模型,每个进程都会有相同的模型和参数。

- 创建数据分发Sampler,使每个进程加载一个mini batch中不同部分的数据。

- 网络中相邻参数分桶,一般为神经网络模型中需要进行参数更新的每一层网络。

- 每个进程前向传播并各自计算梯度。

- 模型某一层的参数得到梯度后会马上进行通讯并进行梯度平均。

- 各GPU更新模型参数。

具体流程图如下:

图1 多机多卡数据并行训练

support.huaweicloud.com/develop-modelarts/modelarts-distributed-0008.html

看了此文的人还看了

CDN加速

GaussDB

文字转换成语音

免费的服务器

如何创建网站

域名网站购买

私有云桌面

云主机哪个好

域名怎么备案

手机云电脑

SSL证书申请

云点播服务器

免费OCR是什么

电脑云桌面

域名备案怎么弄

语音转文字

文字图片识别

云桌面是什么

网址安全检测

网站建设搭建

国外CDN加速

SSL免费证书申请

短信批量发送

图片OCR识别

云数据库MySQL

个人域名购买

录音转文字

扫描图片识别文字

OCR图片识别

行驶证识别

虚拟电话号码

电话呼叫中心软件

怎么制作一个网站

Email注册网站

华为VNC

图像文字识别

企业网站制作

个人网站搭建

华为云计算

免费租用云托管

云桌面云服务器

ocr文字识别免费版

HTTPS证书申请

图片文字识别转换

国外域名注册商

使用免费虚拟主机

云电脑主机多少钱

鲲鹏云手机

短信验证码平台

OCR图片文字识别

SSL证书是什么

申请企业邮箱步骤

免费的企业用邮箱

云免流搭建教程

域名价格

推荐文章

下载AI开发平台MODELARTS用户手册完整版

下载AI开发平台MODELARTS用户手册完整版